NVIDIA於11月18日至21日美國科羅拉多州丹佛舉辦的Supercomputing 2019(SC19)大會中,宣布三項在超級運算領域的進展:與業界生態夥伴打造GPU加速ARM架構伺服器、推出專門處理海量資料的Magnum IO軟體,以及在Microsoft Azure平台推出GPU加速超級電腦。

GPU加速ARM架構伺服器

NVIDIA推出一款參考設計平台,協助超級運算中心、超大規模雲端服務運營商及企業等,可將NVIDIA GPU加速的優點與最新ARM架構伺服器平台結合。此平台是NVIDIA與生態體系合作夥伴如Ampere、Fujitsu及Marvell等共同建構,確保能與ARM架構處理器流暢搭配。

目前全球各大超級運算中心已開始測試GPU加速ARM架構運算系統,包括美國橡樹嶺和桑迪亞國家實驗室、英國布里斯托大學及日本理化學研究所。

Magnum IO套裝軟體

全新NVIDIA Magnum IO軟體可協助資料科學家、AI與高效能運算研究人員在幾分鐘內處理海量資料。經過優化後的Magnum IO能排除儲存及輸入/輸出瓶頸,在執行如財務分析、建立氣侯模型與其他高效能運算作業時,針對多伺服器與多GPU節點提供高達20倍的資料處理效能。

此軟體是NVIDIA與網路及儲存領域業者共同開發出,包括:DataDirect Networks、Excelero、IBM、Mellanox和WekaIO等。

Magnum IO的技術核心是GPUDirect,資料可繞過CPU,在GPU、儲存裝置和網路設備提供的「開放高速公路」上進行傳輸。由點對點及遠端直接記憶體存取(RDMA)組成的GPUDirect與眾多傳輸互連及API相容,包括NVIDIA NVLink、NCCL、OpenMPI及UCX。

在Azure平台推出GPU加速超級電腦

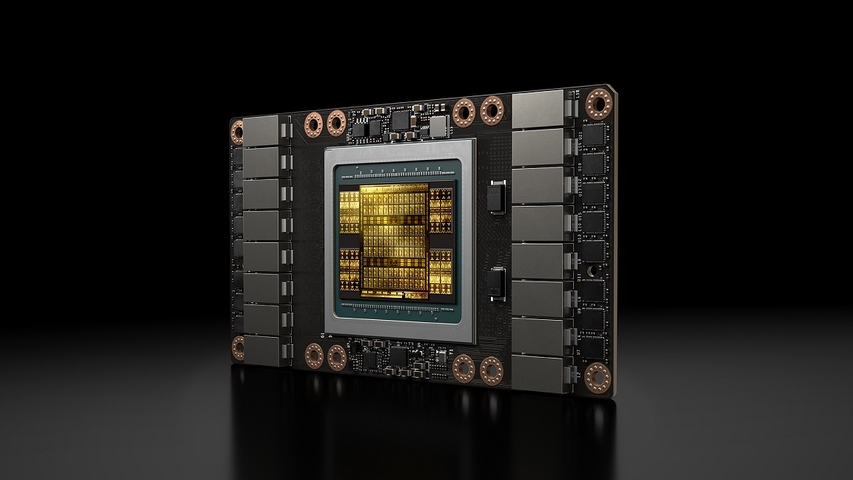

全新Microsoft Azure NDv2執行個體靠單一Mellanox InfiniBand後端網路可串連800個NVIDIA V100 Tensor核心GPU。以往在公司花數個月部署的大規模AI超級電腦,今後可上網依需求租用。

Microsoft與NVIDIA工程師在預先發佈的叢集版本上使用64個NDv2執行個體,只花了約三小時便完成BERT訓練工作,其中有部分利用了NCCL的多GPU優化、NVIDIA CUDA X函式庫與高速Mellanox互連技術。

NDv2目前提供預覽版本,一個執行個體搭配8個NVIDIA V100 GPU可組成叢集並擴大規模,以滿足各類作業負載需求。

from Mobile01 本站新聞 https://ift.tt/2XBhmH7

沒有留言:

張貼留言