發表會完,直到完成第一篇測試感想,其實一直很想寫一篇單獨看「A12仿生」晶片的分享,因為深深覺得A12+iOS12,是這次iPhone Xs、Xs Max,以及iPhone Xr的核心,三款新iPhone所有的提升,幾乎都是來自A12+iOS12這樣的組合。

▌跑個分

雖然比華為的麒麟980晚發表,但A12卻是第一個上市的7奈米製程處理器,這讓A12內放置了更多電晶體(約69億個)。關於奈米製程跟電晶體數量關係,個人覺得科學人這篇文章蠻容易懂的,雖然文章比較舊,但仍可當作補充基礎知識來看。

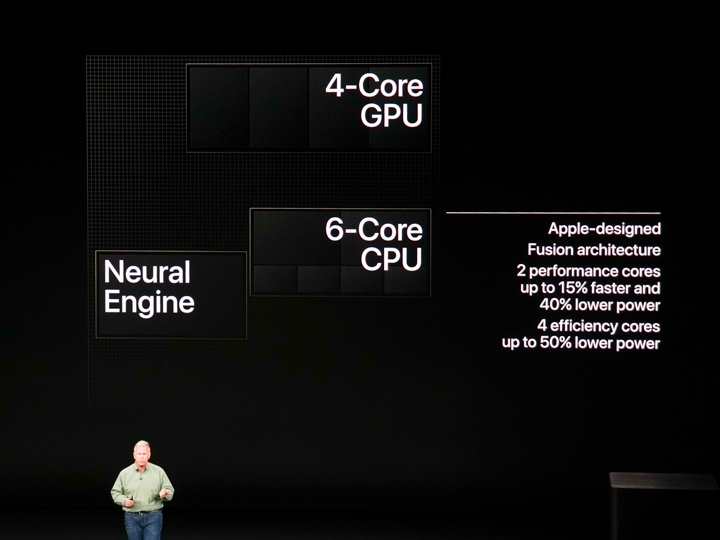

首先看一下A12的架構,一個SoC裡當然包含了很多元件,最主要可以分成四個項目:CPU、GPU、神經網路引擎(Neural Engine)以及 ISP影像處理器。其他還有很多控制單元,如儲存控制、Display Engine、安全隔區....等等。

手機性能表現受CPU影響最大,A12的CPU有六核,2個效能核+4個節能核,這部分跟A11一樣,不一樣的是2個效能核的處理速度比A11高15%,4個節能核功耗降低50%,各自該有的能力都有提升,若要需要,第三代性能管理器也能讓2大4小同時工作,最大化效能。

GPU則從A11的3核增加到4核,圖形處理速度也提升50%。

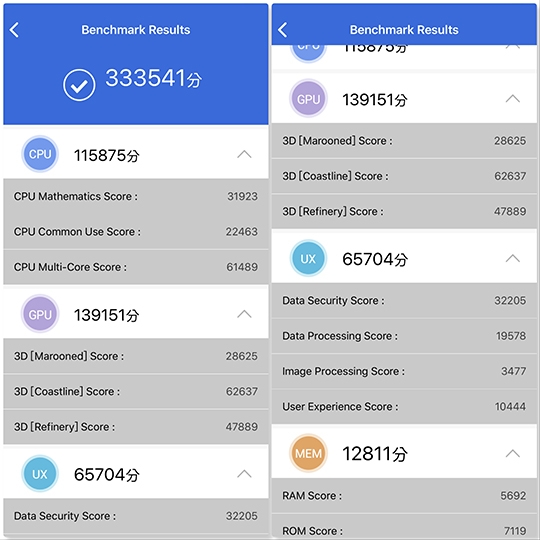

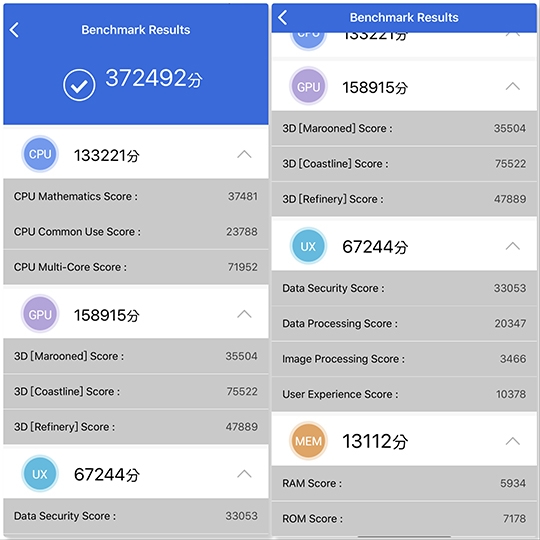

第一部先跑分,

各跑分程式官網也陸續發出兩支iPhone的跑分成績了。

比方安兔兔官方測試iPhone Xs Max跑到37萬2106分,這裡將Xs Max重置後,WiFi連線中並在常溫下,跑出是33萬分。放冰箱+飛航模式則跑出37萬 ,放冰箱並不是正常使用狀況,但因要以跑出最大性能為測試目標,還是一試,兩種結果都讓大家參考。

,放冰箱並不是正常使用狀況,但因要以跑出最大性能為測試目標,還是一試,兩種結果都讓大家參考。

Geekbench 4寫稿時官網上Xs Max單核心/ 雙核心得分各是4794/ 11098,而我在冷氣室內跑出的是4840/ 10930。另外Geekbench上顯示Xs Max RAM約3.65GB(Xs也是)。

實際操作部分,簡單拿A12+iOS12的iPhone Xs,以及A11+iOS12的iPhone 8 Plus比對一下開啟程式的速度,但為何是這兩支? 因為手邊的iPhone就這兩支安裝的程式數量最差不多...

Xs有稍微快一點點,但說真的,都蠻快的了,iPhone Xs開啟程式後到完整出現內容的速度比較快。

[embedded content]

至於GPU性能,發表會上以「The Elder Scrolls: Blades」這款遊戲為例,表現A12即時運算出各種光影及細節的能力,不過這款遊戲之後才會上架,目前這個時間點還沒有很多專為A12打造的遊戲,但我們從跑分,現有遊戲遊戲來看看吧。

GPU這裡用Geekbenck 4來測試,Metal部分寫稿時官網列出的是2萬1772分,而我在冷氣辦公室內跑出了21880,另一次開啟飛航模式跑到更高的22751。

接著用⟪Need For Speed: 飆車無限⟫這個畫面變化快速而且華麗的遊戲來看,地面上的積水倒影、車身上因為前進而要不斷變換的反射、有沒有經過路燈車身亮度也要變化....這些精細快速的變化都有渲染出來(其實對照i8 plus看也效果也很精細XD~)

[embedded content]

目前至少安兔兔跟Geekbench4的跑分,兩支iPhone Xs (A12)的分數都去年的iPhone,也高過Android的機種,不過畢竟Snapdragon 845跟A12不是同一世代的的處理器,這種比較,等到同為7奈米的麒麟980以及下一代Snapdragon 8系列手機出現再看比較準確。

▌更快學習跟即時運算

在A12的架構裡,提升最大的是Neural Engine神經網路引擎。蘋果在去年的A11裡首次加入神經網路引擎這個硬體,負責做跟機器學習功能有關的運算,去年A11裡的神經網路引擎是雙核的,到今年的A12,一舉升級到八核,時脈也提高,運算能力從每秒6千億次,提升到每秒5萬億次...都是天文數字

提到Neural Engine,就一定要搭配認識Core ML,這是蘋果給開發者的機器學習框架,讓開發者更容易在自己的App裡加入機器學習、裝置內學習、訓練模型...等,強化功能。 發表iOS11時,也一併推出這個框架,到了發表iOS12時,也順勢推出升級的Core ML2,根據iPhone發表會上提到,Core ML2加上A12,運算速度可比上一代快上9倍,而且功耗只要1/10。

但這次Neural Engine硬體 + iOS12軟體的提升,會反映在哪裡呢?

反映在「即時」裡。

機器學習是讓系統用海量的資料學習,得出許多模式後,讓系統有自我判斷的能力。

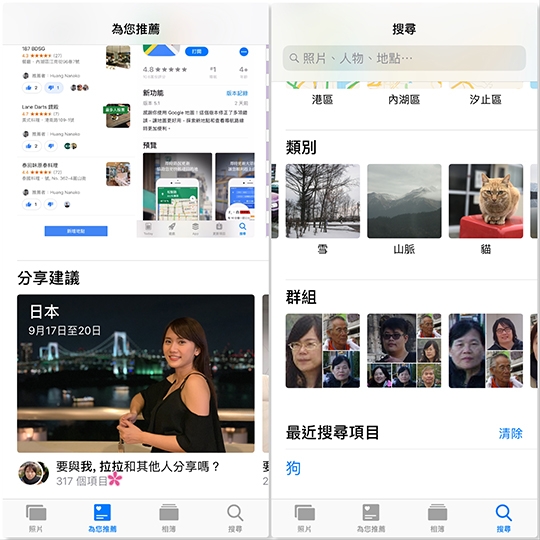

如經過非常大量照片的訓練,讓系統知道貓、天空、食物....等等各種物件的特徵是什麼,於是可以自動辨識出圖片裡有什麼,做出相簿裡非常好用的關鍵字搜尋功能,以及自動整理出回憶相簿。

FaceID也是讓系統經過許許多多臉孔照片、模型的訓練,得以辨認出真臉與假臉特徵上有何不同,以免被3D模型欺騙,以及不受眼鏡、髮型等的改變而無法辨認。

除了相簿及FaceID,目前iOS裡已有很多功能導入機器學習,比方

QuickType預測輸入、

Animoji/ Memoji追蹤超過50種臉部動作,知道是什麼表情並反映出來

TrueTone(原彩顯示)會偵測周遭光線自動微調顯示的白平衡

測量深度訊息做出景深感、在臉上模擬攝影棚燈光、相片辨識...等,也有運用到機器學習。

在iOS12+A12裡,因為機器學習運算速度提升,也讓上述功能的反應會更快。

或許你已經發現兩支iPhone Xs「照片」裡,搜尋能更準確列出已辨識好的類別、事件,回憶相簿的生成速度也變快了,而且很快就能抓出相片裡的人物,建議分享。

兩支iPhone Xs,以及iPhone Xr上的SmartHDR、控制景深、高動態範圍錄影...等拍照上新功能,除了感光元件的受光面積變大之外,也得益於A12整體+神經網路引擎,能即時處理好更複雜的辨識、更大量的運算。

(為何可以做到SmartHDR的效果,可以參閱之前測試裡的說明...)

▌AR辨識更快

CoreML2及A12神經網路引擎的升級,也釋放了GPU的負擔,讓GPU更有余裕處理更複雜、精細、即時的圖形運算,這帶來更好的遊戲畫面,但最能反映這些升級的,是AR App們。大家還記不記得發表會Keynote上介紹了一個非常酷的投籃訓練App「Homecourt」,它可以即時定位每次投籃的位置,並配合有沒有進藍在地面上做不同的標記,此外還可以追蹤投籃類型、腿型角度、出手角度、出手時間、球速、出手高度...等指標。

[embedded content]

要能即時追蹤,需要快速偵測到移動中的這個人這顆球,跟這地面、空間的相對位置,這需要更快的運算速度,開發者在發表會上也提到,這是因為A12及iOS12而做得到的更新。

我也小小試用了一下,目前看來還不是發表會上的那個版本,但投籃之後馬上就可以標記位置跟有沒有進球這些動作仍然非常即時,而且會把給一次上籃分畫面記錄,事後可以一次次回放、慢動作、追蹤人物播放...等,對想訓練投籃精準度,校正上籃動作是個非常好用的App。

[embedded content]

(也可注意影片右上角)

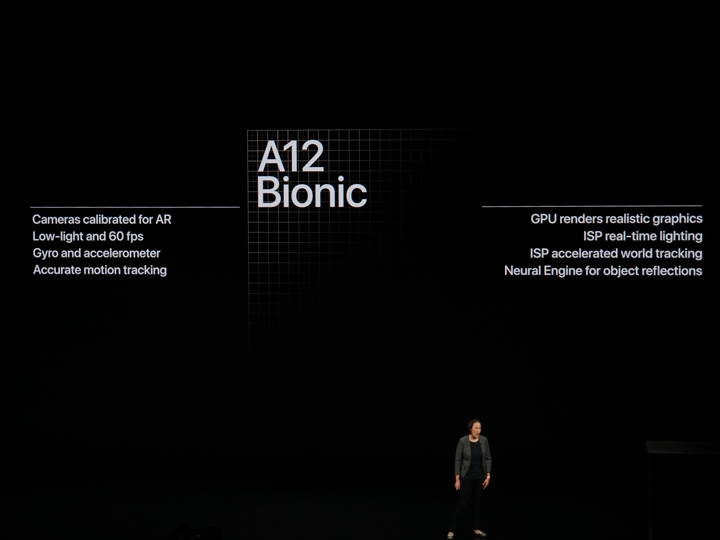

iPhone Xs、Xs Max及Xr上,除了處理器,相機、陀螺儀、加速感應器等都做了校准,GPU即時渲染、ISP做出即時光照感、實境空間追蹤、神經網路引擎演算出實時光照反射感...等,都提升了AR畫面的真實感。

另外的例子是能更快辨識出各種材質、各種光線下的地板、平面,更快定位好放置物件,而且也能更快辨識出這位置在這空間的哪裡、光源方向之類的資訊,讓放在上面的物件即時反映出該有大小、反光、表面材質感...等。iOS12裡有個「AR Quick Look」的功能,能讓你在Safari上看3D模型,就是這樣的應用,未來可以在購物網頁上點開物件,放在真實環境裡觀看更逼真的預覽。

[embedded content]

遊戲也是,ARKit2製作的遊戲可以支援多人參戰,每個人在這空間的哪裡、移動位置後畫面反應又如何...等,都需要大量的運算外,最重要是還要能時反應。

目前這時間點Demo遊戲還沒上架,但這陣子以來的體驗是,以往在iPhone X或iPhone 8 Plus上玩AR不久,就明顯感覺到手機溫度變高,不過在iPhone Xs Max上玩的時候,手機沒那麼容易升溫了,連帶也改善使用AR App時的耗電量了。

每年發表新iPhone時,幾乎都會搭載新的處理器、新的iOS系統,可以說這一個硬體、一個軟體,都是為了讓當年的新iPhone發揮到最好而生。

常聽很多文章以封閉式系統來形容iPhone及iOS,不過我自己覺得更精確來說,應該是一體式系統,從處理器SoC、iPhone硬體、作業系統、功能程式、開發工具...這些從前端到終端,從硬體到軟體,都是蘋果自己設計的,因此在開發iPhone開發過程中,蘋果完全可以掌握硬體和軟體怎麼配合,才能打造出他們想要的功能,這跟多數Android手機處理器、作業系統、ROM、開發工具各來自不同廠商,彼此要花很多時間溝通、研究、修正是很不同的模式。

可能這也造就了一些同學所說的:蘋果可能不是第一個推出什麼功能,但卻是把連貫性跟體驗做到舒服的廠商吧。

#iPhone Xr也是A12啊

from Mobile01 本站新聞 https://ift.tt/2O2eHog

沒有留言:

張貼留言