人工智慧正逐漸滲透到日常生活,其中對話式AI由於使用方便、回應快、易於個人化,已廣為消費者接受。不過對話式AI想進一步應用到更複雜的領域如醫療、金融、通訊等,就需要更大的模型及更快的訓練速度。近日NVIDIA在對話式AI有了突破性發展,並將成果開放原始碼分享,加速了社群研發腳步,也帶來新型態服務的可能性。

對話式AI是被廣泛應用的人工智慧類型之一,圖為對話式AI與人溝通時的螢幕顯示狀況。

NVIDIA於8月13日宣布創下三項自然語言理解效能紀錄:

- 最快訓練:採用內建1,472個GPU的NVIDIA V100 GPUNVIDIA DGX SuperPOD,成功把先進AI語言模型BERT-Large的訓練時間從數日縮短至53分鐘。此外,僅透過一台NVIDIA DGX-2系統在2.8天內就完成BERT-Large訓練。

- 最快推論:以NVIDIA T4 GPU運行NVIDIA TensorRT,在BERT-Base SQuAD資料集上僅用2.2毫秒就完成推論。遠低於許多即時應用要求的10 毫秒門檻,也大幅領先以CPU執行的40毫秒。

- 最大模型:NVIDIA在Transformers Model的基礎上建構與訓練出全球最大的語言模型,擁有83億個參數,足足比BERT-Large多出24倍,也因此NVIDIA把這個計畫稱為Project Megatron。

NVIDIA V100 GPUNVIDIA DGX SuperPOD超級電腦。

對話式AI已發展多年,如聊天機器人、語音助理、智慧音箱、語音搜尋等。但想要達到人類理解力的水準仍極為困難,主要原因是無法即時部署超大規模的AI模型。這次發表的幾項突破,就是在AI訓練與推論方面刷新速度紀錄,同時也建構出至今最大的語言模型。

以自然語言理解技術運行的AI服務,預計在未來幾年呈現指數成長。根據Juniper Research的報告,光是數位語音助理市場規模預計在未來5年內將從25 億美元成長到80億美元。Gartner也預測2021年,15%的客服互動將完全由AI執行,與2017年相比增加400%。

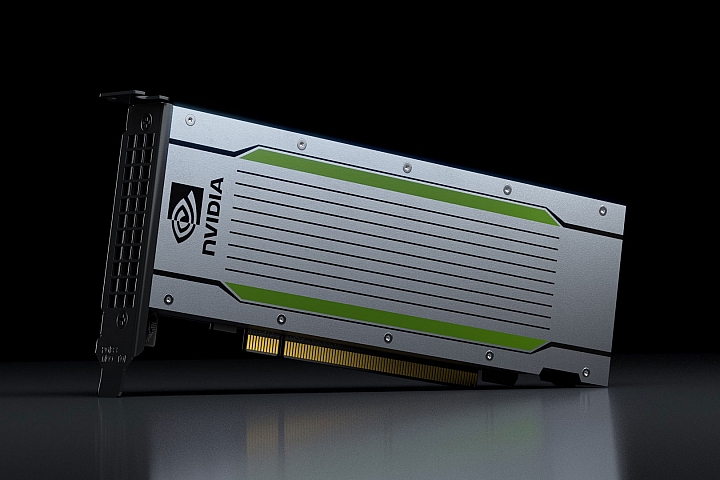

NVIDIA T4 GPU。

NVIDIA即日起也將對話式AI研發成果全面釋出給開發者,包括:

- NVIDIA GitHub BERT模型的訓練程式碼與PyTorch學習框架。

- NGC模型Scripts與TensorFlow的check-points。

- GitHub上針對TensorRT優化的BERT範例。

- Faster Transformer: C++語言API、TensorRT外掛與TensorFlow OP。

- MXNet Gluon-NLP包含AMP對BERT的支援方案(訓練與推論)。

- AI Hub上針對TensorRT優化的BERT Jupyter軟體說明註記。

- Megatron-LM:用來訓練超大型Transformer模型的PyTorch程式碼。

from Mobile01 本站新聞 https://ift.tt/2N3shWO

百家樂/線上投注 http://www.iwin9418.com

真人娛樂 |百家樂、德州撲克、麻將遊戲、21點、13支

六合彩球 | 香港六合彩、 大樂透、 威力彩、 今彩539

電子遊戲 | 水果盤 、 捕魚達人 千炮版 、 骰寶 、 輪盤

黃金期權 | 全新開放 、 股市 、 黃金 、 外幣

百鬼夜行 | 30線、4500倍、拉霸、五鬼運財

沒有留言:

張貼留言